FOUNDRY

Les fondements de la robustesse et de la fiabilité en intelligence artificielle

Aperçu

Développer les fondements théoriques et méthodologiques de la robustesse et de la fiabilité nécessaires pour construire et insuffler la confiance dans les technologies et les systèmes d’IA.

Panayotis Mertikopoulos, Chargé de recherche CNRS

Le projet FOUNDRY met en exergue la notion de robustesse, qui a échappé au domaine depuis ses débuts. La cause en est la suivante : les systèmes d’apprentissage automatiques sont très gourmands en données et très sensibles aux exemples qui leur sont fournis, ce qui fragilise et les limite dans leur champ d’application.

L’objectif est donc de développer les fondements théoriques de cette robustesse et de cette fiabilité.

Mots clefs : Robustesse, fiabilité, théorie des jeux, théorie de l’information, transport optimal, confiance, équité

Site web du projet : En cours de création

Les missions

Nos recherches

Atteindre la résilience en présence d’obstacles centrés sur les données

Développer des algorithmes et des méthodologies pour surmonter les insuffisances des données d’apprentissage (valeurs aberrantes, observations incomplètes, changements d’étiquettes, empoisonnement, etc.), ainsi que de renforcer les modèles contre les obstacles qui pourraient survenir au moment de l’inférence (attaques adversariales).

Favoriser l’adaptation de ces modèles et algorithmes lorsqu’ils sont déployés et qu’ils interagissent entre eux dans des environnements réels

Développer les outils théoriques et techniques nécessaires à ces systèmes d’IA capables de s’adapter instantanément aux environnements non stationnaires et proposer des garanties entre le pire.

Atteindre la robustesse en présence de buts et d’objectifs contradictoires

Délimiter précisément la manière dont ces objectifs interagissent avec les mesures de performance standard et caractériser les limites fondamentales de performance des modèles d’IA lorsque les données sont fournies par des agents égoïstes qui

imposent des changements de distribution délibérés.

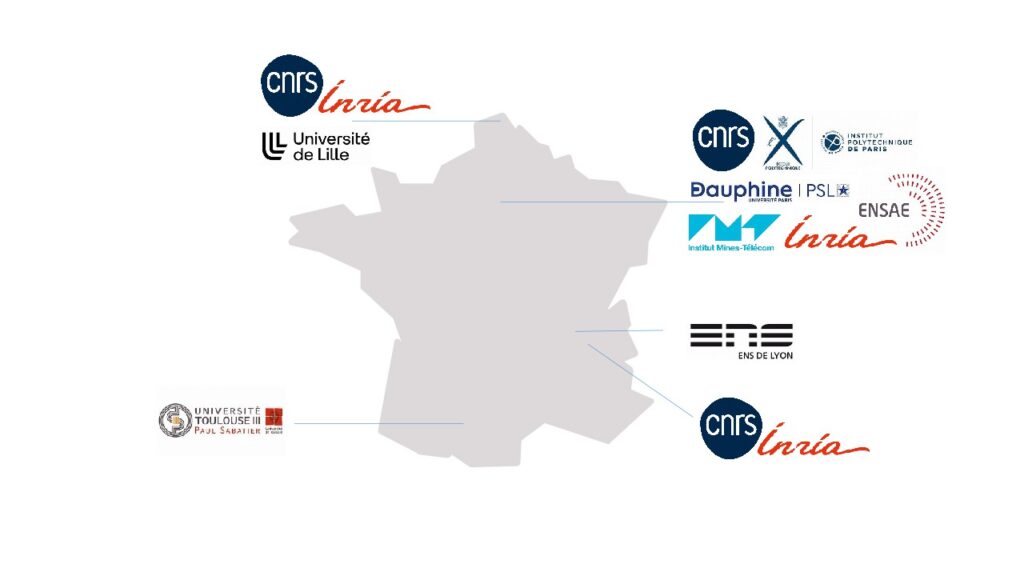

Le consortium

CNRS, Université Paris-Dauphine, INRIA, Institut Mines Télécom, Ecole normale supérieure de Lyon, Université de Lille, ENSAE Paris, Ecole Polytechnique Palaiseau

Le but est d’accélérer la recherche fondamentale en lien avec la conception de systèmes d’IA robustes et fiables.

Les résultats du projet auront un impact significatif sur l’état de l’art dans le traitement des données corrompues, l’apprentissage robuste, et l’incorporation de garanties d’équité et de confidentialité dans les modèles de machine learning actuels et émergents sans sacrifier la performance des modèles.

La propagation fulgurante des algorithmes d’IA – des chatbots polyvalents capables d’imiter des conversations humaines aux systèmes automatisés d’admission à l’hôpital alimentés par l’apprentissage automatique – a soulevé une question cruciale pour l’ensemble de la société : peut-on se fier aux prédictions des modèles d’apprentissage automatique ?

Ce projet s’attache à fournir les fondements théoriques et mathématiques permettant de rendre ces applications fiables et dignes de confiance, et répondre en partie à ces préoccupations de la société concernant l’utilisation généralisée des modèles et des prédictions d’apprentissage automatique

Ce projet vise donc également à stimuler l’innovation pour les grandes entreprises, les PME et les start-ups, en favorisant la collaboration.

Une communauté d’environ 25 chercheurs, enseignants chercheurs et ingénieurs permanents, mobilisant en outre 20 doctorants, 10 post-doctorants et 5 ingénieurs de recherche contractuels au fur et à mesure du projet.

Publications

Autres projets